DALL-E tampaknya mendapatkan sebagian besar perhatian minggu ini, tetapi saya pikir Openclip mungkin akan menjadi lebih penting. Kami telah bereksperimen dengannya minggu ini dan hasilnya tampak hampir terlalu bagus untuk menjadi kenyataan; bahkan dapat mengklasifikasikan spesies jamur dalam foto dari rol kamera saya dengan cukup baik.

Oleh Brad Dwyer di Facebook

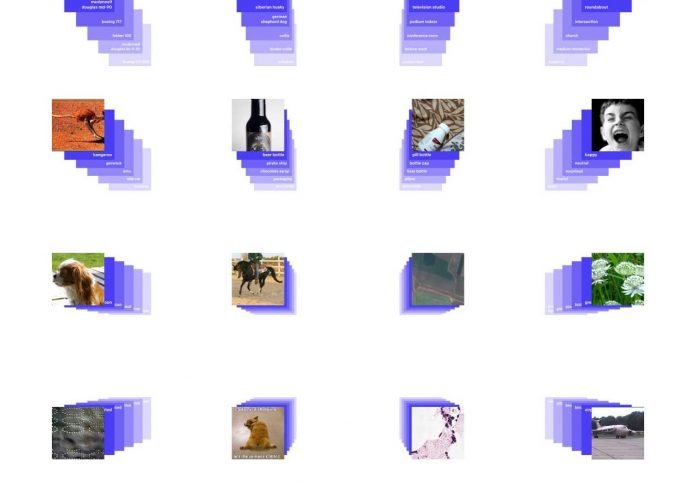

Beberapa hari yang lalu OpenAI merilis 2 model yang mengesankan Openclip dan DALL-E. Sementara DALL-E mampu menghasilkan teks dari gambar, CLIP mengklasifikasikan rentang gambar yang sangat luas dengan mengubah klasifikasi gambar menjadi masalah kesamaan teks. Masalah dengan jaringan klasifikasi gambar saat ini adalah bahwa mereka dilatih pada sejumlah kategori tetap, Open Clip tidak bekerja dengan cara ini, ia belajar langsung dari teks mentah tentang gambar, dan dengan demikian tidak dibatasi oleh label dan pengawasan. Ini cukup mengesankan, CLIP dapat mengklasifikasikan gambar dengan akurasi canggih tanpa pelatihan khusus dataset.

Titik penjualan utama untuk CLIP

OpenAI mencoba untuk menjauh dari metode pembelajaran terawasi konvensional. Misalnya, ImageNet (kumpulan data gambar terbesar) hanya dapat mengklasifikasikan gambar yang termasuk dalam kelas tempat ia dilatih. Tidak masuk akal untuk terus menambahkan kelas baru ke kumpulan data dan melatih kembali jaringan dalam jangka panjang.

Kumpulan data ImageNet, salah satu upaya terbesar di bidang ini, membutuhkan lebih dari 25.000 pekerja untuk membuat anotasi 14 juta gambar untuk 22.000 kategori objek. Sebaliknya, Openclip belajar dari pasangan teks-gambar yang sudah tersedia untuk umum di internet. Mengurangi kebutuhan akan kumpulan data berlabel besar yang mahal telah dipelajari secara ekstensif oleh pekerjaan sebelumnya.

Bayangkan saja berapa biaya untuk mempekerjakan 25.000 pekerja!

Nilai jual utama untuk Openclip adalah klasifikasi gambar zero-shot, ini berarti Anda dapat mengambil sepotong teks dan gambar dan Anda dapat mengirimkannya melalui jaringan dan mendapatkan prediksi seberapa miripnya.

Ini berarti bahwa Anda dapat melakukan klasifikasi tanpa melakukan pelatihan sebelumnya pada kumpulan data Anda untuk kasus penggunaan khusus Anda dan ini sangat mengesankan karena sebelum ini adalah cara hampir semua jaringan klasifikasi dibangun karena Anda akan memiliki kumpulan data khusus yang akan mewakili hal-hal yang ingin Anda klasifikasikan dan kemudian Anda akan memiliki gambar yang cocok dengan itu dan Anda harus mengirimkannya melalui prosedur pelatihan dan pada akhirnya mengeluarkan jaringan Anda di akhir sementara klip memungkinkan Anda mengelak.

Ulasan singkat: Pembelajaran kontrastif

Pembelajaran kontrastif adalah pendekatan untuk merumuskan tugas menemukan hal-hal yang serupa dan tidak serupa untuk model ML. Dengan menggunakan pendekatan ini, seseorang dapat melatih model pembelajaran mesin untuk mengklasifikasikan antara gambar yang mirip dan tidak mirip.

Untuk memahami kekuatan model ini, Anda harus memahami apa itu pembelajaran kontrastif.

Pembelajaran kontrastif telah melihat ledakan minat dalam teknik pembelajaran mandiri terutama dalam visi komputer dengan makalah seperti Simclr dan Moco.

Anda dapat menganggap pembelajaran Kontrastif sebagai masalah yang cocok. Jika Anda ingin mencocokkan gambar kucing dengan gambar lain yang serupa, Anda dapat melakukannya dengan mudah. Pertama, kenali kucing pertama, lalu cari gambar kucing lain. Jadi, Anda dapat membedakan antara hal-hal serupa dan berbeda.

Bagaimana cara melakukannya?

Saya pikir salah satu alasan utama mengapa model ini mengungguli model canggih lainnya adalah karena ia menggunakan campuran teknik NLP dan Computer vision.

1. Pra-pelatihan kontrastif

Metode pra-pelatihan menjadi semakin populer selama beberapa tahun terakhir dan telah merevolusi NLP.

Model dimulai dengan pra-pelatihan kontrastif di mana pasangan teks gambar dicocokkan dengan kesamaan dari sekumpulan gambar. Ini dilakukan dengan menggunakan encoder gambar dan encoder teks.Pra-pelatihan kontrastif mencoba untuk mempelajari representasi urutan invarian kebisingan yang mendorong konsistensi antara representasi yang dipelajari dan urutan aslinya.

Mereka mendapat inspirasi dari VirTex yang merupakan pendekatan prapelatihan menggunakan teks yang padat secara semantik untuk mempelajari representasi visual. Pendekatan ini telah terbukti melampaui pendekatan terawasi lainnya seperti jaringan ImageNet kelas atas klasik.

2. Prediksi Zero-shot (seperti yang dijelaskan di atas)

Ini cukup keren, jika Anda ingin mencobanya sendiri, saya sarankan untuk memeriksa posting blog yang luar biasa ini:

CLIP mengagumkan dan revolusioner, tapi…

Setiap model hebat memiliki keterbatasannya. Meskipun Openclip mengungguli model canggih, ia memiliki beberapa kelemahan.

- Yang pertama adalah ia tidak bekerja dengan baik pada tugas-tugas sistematis seperti menghitung jumlah objek dalam gambar

- Kemampuan generalisasi minggu pada gambar yang tidak tercakup dalam dataset pra-pelatihannya.

- Peka terhadap kata-kata dan ungkapan

Pikiran terakhir dan takeaway

Tujuan artikel ini bukan untuk menghipnotis Openclip karena ini biasanya dilakukan dengan banyak model ML baru. Namun, selalu menyenangkan melihat inovasi dan ide-ide baru. Saya harap Anda mengerti bahwa pengembang CLIP mencoba untuk beralih dari teknik ML tradisional ke teknik yang lebih baru. Saya pikir langkah pertama ke pendekatan yang lebih baru selalu lebih sulit dan saya yakin kita akan melihat pendekatan yang lebih baik yang dibangun di atas CLIP di masa depan. Jika Anda ingin mengetahui lebih lanjut tentang detail teknis Openclip, saya sarankan untuk melihat makalah mereka di sini

Jika Anda ingin menerima ulasan makalah reguler tentang makalah terbaru dalam pembelajaran AI & Mesin, tambahkan email Anda di sini & Berlangganan!

Baca Juga : 4 Tips Cara Manfaatkan Open Clip Art Untuk Proyek Kamu